Gouverner avec l’intelligence artificielle: un état des lieux de l’OCDE sur la transformation des fonctions essentielles de l’État

Republication de l’article rédigé par Le Collectif Citoyen, diffusé sur France-Soir le 3 octobre

L’Organisation de coopération et de développement économiques (OCDE) publie en septembre 2025 un rapport ambitieux intitulé Gouverner avec l’intelligence artificielle: État des lieux et perspectives pour les fonctions essentielles de l’État. Ce document, fruit d’une analyse approfondie de 200 cas d’usage de l’IA dans 11 domaines clés de l’administration publique, dresse un panorama des avancées, des défis et des opportunités offertes par cette technologie. À l’heure où les gouvernements du monde entier peinent à rattraper le secteur privé en matière d’adoption de l’IA, ce rapport – approuvé par le Comité de la gouvernance publique de l’OCDE – vise à guider les administrations vers une utilisation stratégique et responsable de l’IA. Il s’inscrit dans le projet plus large de l’OCDE « Prospérer avec l’IA », soulignant comment cette technologie peut renforcer la productivité, la réactivité et la redevabilité des services publics, tout en alertant sur les risques inhérents.

L’IA, un accélérateur de la transition numérique des administrations

Le rapport met en lumière le rôle croissant de l’IA dans la modernisation des administrations publiques. Alors que la pandémie de COVID-19 a accéléré la numérisation des services (avec des progrès équivalents à plusieurs années en quelques mois), l’IA émerge comme un pilier transformateur. Selon l’OCDE, elle permet d’automatiser 84% des tâches répétitives au Royaume-Uni, libérant ainsi l’équivalent de 1 200 postes à temps plein par an pour des missions à plus haute valeur ajoutée. Les bénéfices sont structurés autour de trois axes principaux: la productivité (efficacité et efficience), la réactivité (adaptation aux besoins des citoyens) et la redevabilité (transparence et détection des anomalies). L’IA intervient à chaque étape du cycle de l’action publique – de la conception des politiques à leur évaluation – pour automatiser les processus, personnaliser les services et anticiper les risques. Par exemple, des agents conversationnels basés sur l’IA répondent aux questions des usagers, tandis que des algorithmes prédictifs aident à la détection de fraudes fiscales ou à la gestion des catastrophes.

Cependant, les administrations publiques traînent des pieds par rapport au privé, en raison de contraintes spécifiques: obsolescence des systèmes d’information, pénurie de compétences, budgets serrés et exigences élevées en matière de protection des données et d’éthique. Le rapport insiste sur le fait que l’inaction est risquée: elle creuse l’écart avec le secteur privé et érode la confiance des citoyens, déjà faible (seulement 39% font confiance à leur administration nationale en 2023).

Une analyse de 200 cas d’usage dans 11 fonctions essentielles

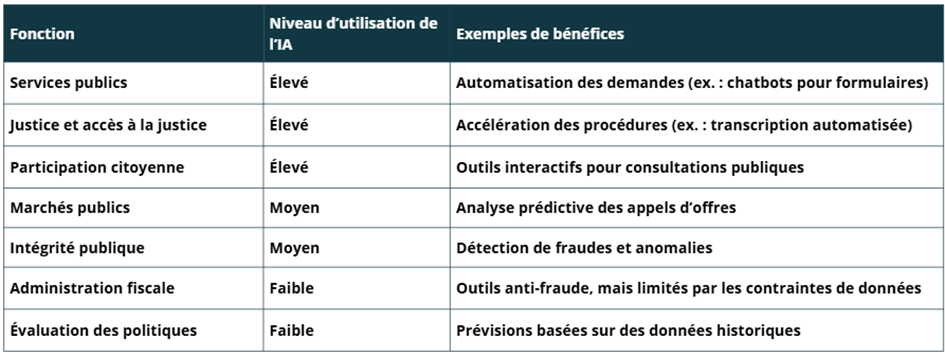

Au cœur du rapport, une étude empirique de 200 cas d’usage de l’IA, couvrant 11 fonctions essentielles de l’État: administration fiscale, gestion des finances publiques, réglementation, réforme de la fonction publique, marchés publics, intégrité publique, évaluation des politiques, participation citoyenne, services publics, maintien de l’ordre/gestion des catastrophes, et administration de la justice/accès à la justice. Ces cas, issus de pays OCDE et partenaires, révèlent des tendances claires.

Les usages les plus courants concernent l’automatisation (77% des cas), la rationalisation et la personnalisation des services. L’IA générative (comme les grands modèles de langage) reste sous-exploitée, bien qu’elle montre un potentiel pour la synthèse de documents ou la rédaction assistée. Les bénéfices concrets incluent une réduction des délais (jusqu’à 90% dans certains cas brésiliens) et une meilleure allocation des ressources.

Malgré ces avancées, 84% des initiatives sont encore en phase pilote, freinées par des défis communs: manque de données de qualité (96% des cas), déficits de compétences (91%), et absence de directives pratiques (85%). Les risques opérationnels (comme les biais algorithmiques) sont omniprésents dans 70% des cas, soulignant la nécessité de garde-fous.

Des exemples concrets: l’IA au service de la justice et des services publics

Le rapport regorge d’exemples inspirants. Dans les services publics, des chatbots comme ceux du Portugal guident les citoyens dans les procédures administratives, rendant les interactions plus inclusives. Pour la participation citoyenne, des outils d’analyse d’opinion basés sur l’IA aident à mieux cerner les perceptions publiques et à adapter les politiques.

Dans l’administration de la justice, l’IA brille par son potentiel à accélérer les procédures. Au Brésil, le système VICTOR examine les pourvois en quelques secondes au lieu de 44 minutes, tandis que Chat-JT, un assistant génératif lancé en 2025, aide les juges à rechercher et synthétiser des documents. En Espagne, HORUS intègre la transcription automatisée pour naviguer rapidement dans les enregistrements d’audiences. En Colombie, PretorIA présélectionne les tutelas (actions pour droits humains) en appliquant des critères transparents, sous supervision humaine.

Un cas particulièrement marquant est celui de l’Argentine, où ChatGPT est utilisé depuis mai 2024 par le ministère public de Buenos Aires pour analyser des affaires d’emploi public. L’outil classe les documents, propose des modèles et rédige des décisions, réduisant le temps de rédaction d’une heure à 10 minutes. À ce jour, il a traité 20 décisions judiciaires, démontrant un gain d’efficience notable. Et tout cela sans avoir passé un concours de l’école de magistrature!

Les limites et risques: une vigilance accrue s’impose

Malgré ces avancées prometteuses, le recours à l’IA dans des domaines sensibles comme la justice pose des défis éthiques et sociétaux majeurs. Prenons l’exemple argentin de ChatGPT utilisé pour 20 décisions judiciaires: si cet outil réduit drastiquement les délais de rédaction (d’une heure à 10 minutes), il soulève des interrogations profondes sur la délégation d’une telle responsabilité à une machine. Les délibérés, traditionnellement longs et réfléchis par des humains, risquent de perdre leur essence humaine au profit d’algorithmes entraînés sur des bases de données potentiellement biaisées – reflétant des inégalités historiques, des stéréotypes ou des lacunes culturelles.

N’est-ce pas dangereux de confier l’interprétation du droit à une IA, dont les « raisonnements » sont opaques et non traçables, probablement programmée hors de la juridiction, sans nommer la personne physique responsable de l’acte final? Les biais cognitifs en pagaille sont prévisibles: faux positifs pouvant mener à des injustices (comme des évaluations erronées de risques de récidive), ou une déresponsabilisation des juges, érodant la confiance publique. Sans garde-fous renforcés – audits transparents, supervision humaine obligatoire et voies de recours – l’IA pourrait amplifier les inégalités plutôt que les corriger, transformant la justice en un système impersonnel et potentiellement discriminatoire.

À cela s’ajoute un problème crucial de juridiction qui n’est pas réellement adressé dans le rapport: les codes sources de ces machines, comme ChatGPT développé par OpenAI aux États-Unis, sont programmés souvent en dehors de la juridiction nationale et ne sont pas transparents. N’est-ce pas renier la souveraineté de sa justice – l’un des quatre pouvoirs fondamentaux de l’État – que de la sous-traiter à une organisation étrangère? Cette dépendance externe expose à des risques d’ingérences majeurs, menaçant l’indépendance et l’autonomie d’un pays. Par exemple, des mises à jour algorithmiques imposées par le fournisseur pourraient altérer les décisions judiciaires sans contrôle local, ou des failles de sécurité pourraient permettre une influence étrangère sur des affaires sensibles. Sans souveraineté numérique affirmée – via des outils open-source ou des régulations strictes sur la localisation des données – les États risquent de céder une part de leur autorité judiciaire à des géants technologiques non alignés sur leurs intérêts nationaux.

Vers une IA digne de confiance dans l’administration

Le rapport conclut sur une vision optimiste, mais pragmatique: pour exploiter l’IA sans la subir, les gouvernements doivent déployer des catalyseurs (gouvernance des données, compétences, investissements), des garde-fous (règles éthiques, transparence sur le cycle de vie des outils) et des mécanismes de dialogue (implication des citoyens et parties prenantes). Prioriser les applications à faible risque et haut impact, comme l’automatisation administrative, est essentiel pour bâtir la maturité.

L’OCDE appelle à une base de preuves croissante via une plateforme dédiée (oecd.ai/gov), invitant les pays à mutualiser expériences et leçons. En fin de compte, gouverner avec l’IA n’est pas une option technique, mais un enjeu démocratique: elle peut restaurer la confiance en rendant les États plus efficaces et équitables, à condition d’être canalisée par une approche centrée sur l’humain.

Ce rapport, riche en analyses et exemples, offre un guide précieux pour y parvenir.

Une question subsiste, étant donné la complexité des Traités de l’Union européenne (TUE) et du Traité de fonctionnement de l’UE (TFUE), et l’absence d’identité des personnes qui auraient rédigé ces documents fastidieux, se pourrait-il que l’UE se soit dotée de ces textes à partir des travaux d’une IA générative?

Citation du rapport: OCDE (2025), Gouverner avec l’intelligence artificielle: État des lieux et perspectives pour les fonctions essentielles de l’État, Éditions OCDE, Paris, https://doi.org/10.1787/6816434b-fr

Pensez à vous abonner ou à faire un don.

Pourquoi l’IA isation se ferait elle avec des « garde fous » diffèrents de la vaxination ?

Quelle rigolade !

Nous sommes déjà un boulet pour les machines , plusse elles se perfectionnent plusse nous serons chiants pour elles .

Je vous laisse le mot de la fin de mon commentaire , moi je peux pas l’ecrire , trop mort de rire .